结合专家经验的深度Q网络信号控制优化算法

(佳都科技集团股份有限公司, 广州 510660)

摘要: 科学合理的交通信号控制方案通过优化路权分配, 有效减少车辆等待时间, 提升交叉口的通行效率, 从而实现更高效的道路资源利用。随着强化学习和人工智能技术的持续发展, 交通信号灯控制算法得到了不断改进和优化。然而, 以往基于强化学习的信控方案优化模型研究大多侧重于智能体的学习过程改进, 较少关注信号控制方案的输入。为更有效地提高交叉口通行效率, 本研究提出了一种结合专家经验的深度Q网络 (Deep Q Network, DQN) 信号控制优化算法。该算法首先设计定时信号配时方案, 然后在微观交通仿真环境SUMO中利用DQN算法进行训练, 以获得交叉口的最优信号控制执行方案。由于定时信号配时方案是基于交叉口的道路条件、流向及实际车流量计算得到的, 输入的信号控制方案更为合理。本研究在华穗路与花城大道交叉口开展实验, 得出了以下结果: 与现实信号控制方案相比, DQN算法和结合专家经验的DQN优化算法均将交叉口的平均速度提高了7. 9%; DQN算法将平均等待车辆数量降低了23. 1%, 结合专家经验的DQN优化算法将其降低了69. 2%。实验结果表明, 应用这两种优化算法都能够有效提升交叉口的通行效率, 其中结合专家经验的DQN信号控制优化算法在所有算法中表现最佳。

关键词: 强化学习, 深度Q 网络, 微观交通仿真, SUMO, 定时信号配时方案

引用格式: 王慧, 叶曦昊. 结合专家经验的深度Q网络信号控制优化算法[J]. 交叉科学学报, 2025, 2(2): 86-92.

文章类型: 研究性论文

收稿日期: 2025-05-26

接收日期: 2025-06-06

出版日期: 2025-06-28

1 引言

近年来,伴随着经济的持续增长与城市化水平的不断提升,城市交通流量迅速上升,进而使交通拥堵现象在城市中频繁出现[1]。目前,交通拥堵已成为影响大城市居民出行的主要因素,并且带来了交通事故风险的上升和碳排放的增加[2-4]。为此,各地纷纷采取多种交通管理措施,以缓解交通拥堵、改善交通环境并提升交通安全水平[5]。研究指出,在众多交通管理措施中,信号控制是提升交叉口运行效率的关键手段之一[6]。

交通信号的主要功能是分配道路交叉口的车辆通行权,科学设计的信号控制方案能够显著提升交叉口的通行效率[7]。近年来,随着强化学习等人工智能技术的出现与持续发展,交通信号灯控制算法得到了持续改进和优化[8-10]。

刘义等[11]利用人工智能信号控制联合创新(TrafficGo)的智能体强化学习技术优化了交通信号灯的控制模式。实验结果表明,在深圳市的8个试点路口,交通通行能力均有所提升。Li[12]等提出了一种多代理深度确定性策略梯度方法用于解决自适应交通信号控制问题。为了加速强化学习的收敛并接近最优解,Mohammad等[13]研究了基于持续残差强化学习(CR-TSC)的自适应交通信号控制器,成功将车辆的平均行程时间减少了15%。此外,Park等[14]利用DQN算法构建了孤立交叉口和协调交叉口的交通信号控制模型,并在Vissim仿真环境中对该模型进行了评估与验证。

强化学习等算法在优化交通信号灯控制方面具有重要意义。然而,上述学者们的研究大多侧重于强化学习模型智能体的学习过程改进,较少关注信号控制方案的输入,而信号控制方案的优劣对交叉口通行效率的提升至关重要。为更有效地优化交叉口信号控制以提升交通流畅性,本研究提出一种结合专家经验的DQN优化算法。该算法首先根据交叉口的道路条件、各进口道流向和车流量设计定时信号配时方案,然后利用DQN算法在微观交通仿真环境中进行训练,来得到交叉口最优的信控执行方案。

2 研究区域概况

本文选取的研究区域为华穗路与花城大道交叉口。该交叉口位于广州市中心的繁华地带——天河区珠江新城区域,是重要的交通枢纽之一。华穗路是珠江新城中央商务区(CBD)核心区的一条市政道路,花城大道则为天河区东西向主干道,承担着区域内大量的交通通行需求。这两条道路的交会处形成了交通流量密集的交叉口,是城市交通流动的关键节点。

华穗路与花城大道交叉口交通流量大,尤其在早晚高峰时段经常出现较为严重的交通拥堵情况,表现为车道排队长度较长、通行效率低下、易发生交通冲突等问题。该交叉口是典型的“十”字形交叉口,其东、南、西、北四个方向均设有进口道,其中东西向进口道各设6条车道,南北向进口道各设2条车道。

3 数据来源

Open Street Map(OSM,官方网址:https://www.openstreetmap.org)是一种由全球用户共同维护的免费开源、可编辑地图服务,广泛用于获取道路网络等地理空间数据[15]。本文所使用的华穗路与花城大道交叉口路网数据来源于OSM平台,所提取的地图数据采用WGS84地理坐标系。在此基础上,本文结合研究区域的厘米级高精度地图信息,对原始OSM路网数据进行了二次编辑,构建了车道级精度的交通仿真路网。

车辆轨迹数据来源于交叉口前端设备检测数据。数据采集时间为2024年11月13日19:00:00至19:15:00,涵盖15分钟的晚高峰典型时段,能够真实反映交叉口在高车流量条件下的交通运行特征。

4 研究方法

4.1 仿真环境搭建

微观交通仿真是基于车辆运动的微观行为模型,借助计算机技术对交通流的时空演化过程进行动态复现,能够用于分析和评估各类交通影响因素,为交通问题研究与决策提供技术支持[16]。SUMO(Simulation of Urban Mobility)是一款开源的交通仿真软件,基于车辆跟驰模型等方法,能够实现车辆级的交通仿真[17]。SUMO提供了直观、灵活且高效的交通仿真能力,广泛应用于交通信号控制系统的测试与优化,尤其适用于复杂城市交叉口拥堵机理与演化规律的研究。

在执行SUMO仿真前,需要准备路网文件(.net.xml)、车流文件(.rou.xml)和配置文件(.sumocfg)。其中,路网文件包含了车道位置、形状、限速、连接关系、路权规则和交通信号灯等路网信息;车流文件定义了交通流量与车辆生成规则;配置文件将路网和车流等文件关联起来,实现模拟仿真。此外,SUMO可设置信控方案切换信息和检测器等,并将其保存为附加文件(.add.xml),通过配置文件加载至交通仿真过程中。

在本研究中,构建了华穗路与花城大道交叉口的仿真路网文件,如图1所示。该交叉口南北方向进口道各设有1条直左合用车道和1条直右合用车道;东进口道设置有1条右转车道、3条直行车道、1条左转车道及1条左转-掉头混合车道;西进口道设置有1条右转车道、3条直行车道和2条左转车道。

车流数据来源于2024年11月13日19:00:00至19:15:00期间的车辆轨迹数据,覆盖晚高峰典型时段。仿真附加文件中包含该时段内的信号灯控制信息和多个检测器设置,用于记录各进口道的平均速度关键交通指标。

上述所有文件通过配置文件进行统一集成,仿真起止时间设置为19:00:00至19:15:00,仿真步长为1秒。在仿真过程中,通过TraCI接口实现对仿真过程中车辆状态和红绿灯信号相位的动态获取与控制。

图1 华穗路与花城大道交叉口路网

Fig.1 The road network at the intersection of Huasui Road and Huacheng Avenue

4.2 结合专家经验的DQN信控优化算法

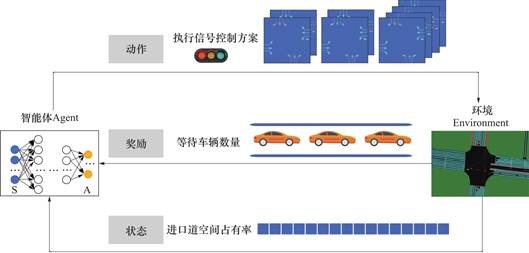

强化学习(Reinforcement Learning,RL)主要包括以下核心要素:智能体(Agent)、环境(Environment)、状态(State)、动作(Action)和奖励(Reward)[18]。在强化学习框架中,智能体与环境进行连续的交互:在t时刻,环境处于某个状态,智能体获取该状态的观测值,并根据预设策略选择一个动作,该动作将改变环境及其状态。随后,智能体获得新状态的观测值及由该动作带来的奖励。由此,智能体就可以根据新的观测值做出新的行动,形成状态-动作链条,如式(1)所示:

![]() (1)

(1)

式中,st、at分别表示t时刻的状态和动作。

强化学习的核心在于最大化智能体在长期交互过程中的累计回报。Q-Learning作为一种经典的值函数强化学习算法,旨在状态s下执行动作a所能获得的期望累计回报。其迭代更新公式如式(2)所示:

![]() (2)

(2)

式中,q(s,a)表示当前状态s和行动a下按照策略行动产生的长期回报期望,N表示样本数量,r表示奖励值。

然而,Q-Learning 的状态-动作空间随着问题复杂度增加而迅速膨胀,面临“维度灾难”的问题。为解决这一问题,DQN应运而生[19]。DQN使用深度神经网络得到对应行动的价值估计,结合![]() 策略在探索与利用之间取得平衡,并采用Replay Buffer存储交互的样本信息,避免数据相关性导致训练不稳定。同时引入目标网络(Target Network),在一段时间内固定网络参数,从而降低训练波动,提升收敛效果。

策略在探索与利用之间取得平衡,并采用Replay Buffer存储交互的样本信息,避免数据相关性导致训练不稳定。同时引入目标网络(Target Network),在一段时间内固定网络参数,从而降低训练波动,提升收敛效果。

在本研究中,为优化红绿灯信号控制算法,DQN的动作空间不仅包括实际运行中的信控方案,还融入了结合专家经验设计的2套定时信号控制配时方案,共同构成动作空间。

参考国内外现有配时方法,结合我国城市交通实际情况,定时信号配时方案设计如下[6,20]。

信号周期C取决于交叉口交通特性,其表达式如式(3)所示:

![]() (3)

(3)

式中,L表示信号总损失时间,计算公式如式(4)所示:

![]() (4)

(4)

式中,Ls表示启动损失时间,A表示黄灯时长,I表示绿灯间隔,k表示一个周期内的绿灯间隔数。

Y表示流量比总数,计算如式(5)所示:

(5)

(5)

式中,Y是组成周期的全部信号相位的各个最大流量比之和;j表示一个周期内的相位数;yj、y'j表示第j相的流量比;qd是设计交通量,Sd是设计饱和流量。需要注意的是,Y值需小于0.9,否则需重新设计信控方案。

确定信号周期后,总有效绿灯时间按照式(6)计算:

![]() (6)

(6)

信号周期内各相位有效绿灯时间如式(7)所示:

![]() (7)

(7)

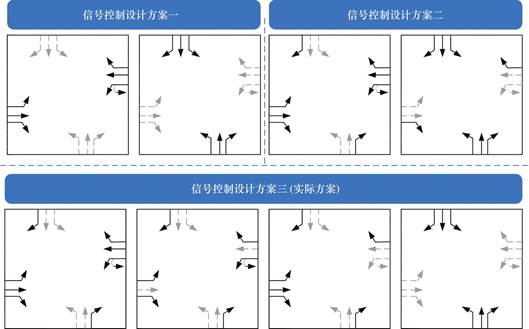

基于上述方法,本文设计了2套两相位定时信号配时方案,详见图2。在这2套配时方案中,相位一的绿灯配时为40秒,黄灯配时为3秒;相位二的绿灯配时为24秒,黄灯配时为3秒,红灯配时为1秒。经计算,两套方案的Y值均为0.8,满足Y<0.9的要求。

图2 交叉口定时信号配时方案(图中位于上方的2个信控方案为本文设计方案,均为两相位;位于下方的信控方案为现实运行方案,为四相位)

Fig.2 Timed signal control schemes for the intersection(The two signal control schemes at the top are the designs proposed in this study,both with two phases;the scheme at the bottom is the real-world operational scheme,which consists of four phases)

图3 结合专家经验的DQN信控优化算法

Fig.3 DQN signal control optimization algorithm combined with expert experience

综上所述,如图3所示,本文将状态空间定义为各方向进口道车辆的空间占有率,如式(8)所示:

![]() (8)

(8)

式中,St表示t时刻的状态,Sj表示编号为j车道的空间占有率。

动作空间则由3种信控方案(1个实际运行的三相位信控方案,2个两相位设计方案)及其各自的相位执行顺序组合而成。也就是说,在执行完一个信控方案后,可以在3个信控方案中选择1个信控方案作为执行方案,并且需要选择方案内各相位的执行顺序。因此,动作空间表示如式(9)所示:

![]() (9)

(9)

式中,ai表示某个信控方案下特定的相位执行顺序。

考虑到进口道上等待车辆数量越多,表示该方向通行需求越大,若未及时放行,将可能引发拥堵。因此,本文将奖励函数设计如式(10)所示:

![]() (10)

(10)

式中,rt表示t时刻的奖励值,j表示所有交叉口方向进口道车道号,N为参考值(本文中设为26,即实际信控方案下的平均等待车辆数)。奖励值越大表示控制策略越优,能更有效减少交叉口的拥堵。

5 结果

为评估结合专家经验的DQN优化算法的效果,本文选取了交叉口平均等待车辆数量、平均速度这2个交通运行指标来作为衡量信号控制优化效果的依据。其中,平均等待车辆数量是每次黄灯结束后的10秒,各进口道等待车辆数量的平均值;交叉口平均速度则是通过SUMO探测器计算的各进口道在仿真时间内通行车辆的平均速度。同时,将本文提出的优化算法与实际信号控制方案以及传统DQN算法进行了对比,以全面评估信号控制优化算法的性能。

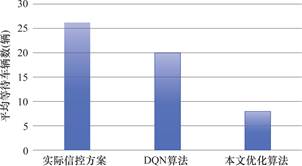

图4显示了该交叉口分别在现实情况下、DQN算法和结合专家经验的DQN优化算法这3种信号控制算法下的平均等待车辆数量,分别为26、20和8辆。结果显示,相较于现实信控方案,DQN算法将平均等待车辆数量降低了23.1%;而结合专家经验的DQN优化算法将其降低了69.2%。这一结果表明,结合专家经验知识的DQN信控优化算法显著减少了交叉口的等待车辆数量。

图4 3种信号控制算法下计算的平均等待车辆数量

Fig.4 Average number of waiting vehicles calculated under three signal control algorithms

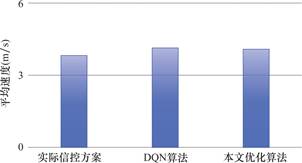

图5显示了该交叉口3种信号控制算法下的平均速度。与现实信号控制方案相比,DQN算法和结合专家经验的DQN优化算法均将交叉口平均速度提高了7.9%。这一结果表明,应用这两种优化算法都能够有效提升交叉口的通行效率,减少交通延误。

图5 3种信号控制算法下计算的平均速度

Fig.5 Average speed calculated under three signal control algorithms

6 结论

本文以华穗路与花城大道交叉口为研究对象,通过交通仿真平台SUMO构建仿真环境,进而获得路网的实时运行状态。然后,利用结合专家经验的DQN优化算法进行交叉口红绿灯信控优化。最后,结合仿真过程中计算得到的平均等待车辆数量和平均速度这2个交通运行指标,对优化算法的效果进行综合分析与评估。

研究结果表明,DQN算法和结合专家经验的DQN优化算法在信号控制方面皆具有较好的优化效果。而本文提出的结合专家经验知识的DQN信控优化算法在这3个算法中表现最佳,显著提升了交叉口通行能力。

利益冲突: 作者声明没有利益冲突。

[⑤] *通讯作者 Corresponding author:王慧,wang_hui0625@163.com

收稿日期:2025-05-26; 录用日期:2025-06-06; 发表日期:2025-06-28

参考文献(References)

[1] 郭继孚, 刘莹, 余柳. 对中国大城市交通拥堵问题的认识[J].城市交通, 2011, 9(02): 8-14+6.

https://doi.org/10.13813/j.cn11-5141/u.2011.02.006.

[2] 陈飞, 诸大建, 许琨. 城市低碳交通发展模型、现状问题及目标策略———以上海市实证分析为例[J]. 城市规划学刊, 2009(06): 39-46.

[3] 冯海霞, 王琦, 杨立才, 等. 拥堵环境下道路交通对城市空气质量的影响[J].山东大学学报(工学版), 2021, 51(01): 128-134.

https://doi.org/10.6040/j.issn.1672-3961.0.2020.211.

[4] Levy, Jonathan I. , Jonathan J. Buonocore, and Katherine V S. Evaluation of the public health impacts of traffic congestion: a health risk assessment[J]. Environmental health, 2010, 9(65): 1-12.

https://doi.org/10.1186/1476-069X-9-65.

[5] Kiunsi, Robert B. A review of traffic congestion in Dar es Salaam city from the physical planning perspective[J]. Journal of sustainable development, 2013, 6(02): 94.

https://doi.org/10.5539/JSD.V6N2P94.

[6] 吴兵, 李晔. 交通管理与控制[M]. 北京: 人民交通出版社, 2020: 169-183.

[7] 蔡锦德. 城市道路交叉口的信号配时优化研究[D]. 北京交通大学, 2012.

[8] 高航, 王伟光. 基于深度强化学习的道路信号灯控制算法[J]. 计算机仿真, 2021, 38(10): 154-159.

[9] Wei, Hua, et al. Recent advances in reinforcement learning for traffic signal control: A survey of models and evaluation[J]. ACM SIGKDD explorations newsletter, 2021, 22(02): 12-18.

https://doi.org/10.1145/3447556.3447565.

[10] Rasheed, Faizan, et al. Deep reinforcement learning for traffic signal control: A review[J]. IEEE Access, 2020, 8: 208016-208044.

https://doi.org/10.1109/ACCESS.2020.3034141.

[11] 刘义, 何均宏. 强化学习在城市交通信号灯控制方法中的应用[J]. 科技导报, 2019, 37(06): 84-90.

[12] Li Z, Xu C, and Zhang G. A deep reinforcement learning approach for traffic signal control optimization[J]. arxiv, 2021, arXiv: 2107. 06115.

https://doi.org/10.48550/arXiv.2107.06115.

[13] Mohammad A, Stefan S, and Marco W. Continuous residual reinforcement learning for traffic signal control optimization[J]. Canadian Journal of Civil Engineering, 2018, 45(8): 690-702.

https://doi.org/10.1139/cjce-2017-0408.

[14] Park S, Han E, Park S, Jeong H, Yun I. Deep Q-network- based traffic signal control models[J]. PLoS ONE, 2021, 16(9): e0256405.

https://doi.org/10.1371/journal.pone.0256405.

[15] Haklay, Mordechai, and Patrick W. Open streetmap: User-generated street maps[J]. IEEE Pervasive computing, 2008, 7(04): 12-18.

https://doi.org/10.1109/MPRV.2008.80.

[16] 周晨静, 张蕊, 刘思杨等. 微观交通仿真理论与实训 [M]. 北京: 机械工业出版社, 2020: 5-11.

[17] Lopez, Pablo A, et al. Microscopic traffic simulation using sumo[C]. 2018 21st international conference on intelligent transportation systems(ITSC), Maui, HI, USA, 2018: 2575-2582.

https://doi.org/10.1109/ITSC.2018.8569938.

[18] 冯超. 强化学习精要: 核心算法与TensorFlow 实现[M]. 北京: 电子工业出版社, 2018: 173-202.

[19] Mnih, Volodymyr, et al. Human-level control through deep reinforcement learning[J]. nature, 2015, 518(7540): 529-533.

https://doi.org/10.1038/nature14236.

[20] 马万经, 吴兵. 现代交通管理与控制概论[M]. 北京: 高等教育出版社, 2019: 149-156

Deep Q-Networks Signal Control Optimization Algorithm Combined with Expert Experience

(PCI Technology Group Co. , Ltd. , Guangzhou 510660, China)

Abstract: A scientifically reasonable traffic signal control scheme optimizes the allocation of road rights, effectively reduces vehicle waiting time, improves intersection traffic efficiency, and achieves more efficient utilization of road resources. With the continuous development of reinforcement learning and artificial intelligence technologies, traffic signal light control algorithms have been constantly improved and optimized. However, previous studies on optimization models of signal control schemes based on reinforcement learning mostly focused on the improvement of the learning process of agents, and paid less attention to the input of signal control schemes. To improve the traffic efficiency of intersections more effectively, this study proposes a Deep Q Network (DQN) signal control optimization algorithm combined with expert experience. This algorithm first designs a timing signal timing scheme, and then uses the DQN algorithm for training in the microscopic traffic simulation environment SUMO to obtain the optimal signal control execution scheme of the intersection. Since the traffic signal timing scheme is calculated based on the road conditions, flow direction and actual traffic volume of the intersection, the input signal control scheme is more reasonable. This study conducted experiments at the intersection of Huasui Road and Huacheng Avenue and obtained the following results: Compared with the actual signal control scheme, both the DQN algorithm and the DQN optimization algorithm combined with expert experience increased the average speed of the intersection by 7. 9%; The DQN algorithm reduced the average number of waiting vehicles by 23. 1%, and the DQN optimization algorithm combined with expert experience reduced it by 69. 2%. The experimental results show that the application of both of these two optimization algorithms can effectively improve the traffic efficiency of intersections. Among them, the DQN signal control optimization algorithm combined with expert experience performs the best among all algorithms.

Keywords: Reinforcement learning, deep Q-networks, microscopic traffic simulation, SUMO, traffic signal timing scheme

Citation: WANG Hui, YE Xihao. Deep Q-networks signal control optimization algorithm combined with expert experience[J]. Acta Interdisciplinary Science, 2025, 2(2): 86-92.